2024生成式大模型安全评估白皮书:全面解析风险与评估方法

时间:2025-01-06 18:10

小编:小世评选

随着人工智能技术的迅猛发展,生成式大模型(Generative Large Models, GLMs)已经逐渐渗透到各个行业和领域,成为推动社会进步和技术创新的重要力量。这些强大的模型在提升效率、创造价值的同时,也面临着诸多安全风险。因此,《2024生成式大模型安全评估白皮书》应运而生,旨在对这一新兴领域的安全状况进行全面剖析,并提供系统化的评估方法。

1. 发展现状与技术演进

报告回顾了众多生成式大模型的发展历程。以OpenAI的GPT系列为例,自GPT-1起,模型的参数规模、性能、功能等方面都经历了显著的提升,新版本GPT-4o及其后续版本在自然语言处理和生成方面表现愈加优秀。Meta的LLaMA系列逐步演进,以其开源特性和优异性能吸引了大量关注,也推动了研究人员和开发者的参与。

在国内,专注于生成式大模型的技术创新也呈现出蓬勃发展的态势,各类国产大模型纷纷崭露头角,具备不同的特色和应用场景。文生图模型如DALL-E系列和Midjourney等的兴起,推动了视觉内容生成的发展,丰富了多模态大模型在综合处理多种数据方面的应用。

2. 安全风险的多维视角

尽管生成式大模型在各行各业中广泛应用,但其背后的安全风险却引发了广泛的关注。该白皮书将安全风险大致划分为三方面:伦理风险、内容安全风险和技术安全风险。

伦理风险:模型可能在数据训练过程中加剧性别和种族偏见,产生误导性的信息,传播不良意识形态。生成式大模型在教育和学术一体化时,也可能对学术伦理产生负面影响,冲击社会就业并影响人类价值观的形成。

内容安全风险:该部分主要涵盖可信与恶意使用、隐私保护和知识产权等问题。大模型有潜力被滥用,例如生成恶意软件、传播虚假信息、侵犯个人隐私,引发知识产权纠纷等。

技术安全风险:从技术角度来看,生成式大模型存在多种安全隐患,包括对抗样本、后门攻击、Prompt注入、数据投毒以及越狱攻击等威胁。这些安全隐患不仅影响模型的可靠性,同时也直接危害用户的安全。

3. 安全评估方法的多元化

为了有效地识别和评估生成式大模型的安全性,白皮书提出了一系列的评估方法。评估的维度主要包括伦理性、事实性、隐私性与鲁棒性,针对这些维度可设计出一系列指标进行量化评估。

报告中还通过实例分析了各类模型的评估框架,如大语言模型(HELM和Trustworthy LLMs等)、文生图模型(HEIM评估基准)、多模态大模型(T2VSafetyBench和MLLMGUARD评估套件)等。通过具体案例,白皮书展示了不同生成式大模型在安全评估过程中的优缺点,并为模型开发和使用提供了重要参考。

4. 面向未来的安全评估方向

为了更好地应对不断变化的安全挑战,报告认为生成式大模型的安全评估需要关注自主演进的能力。具体措施包括:

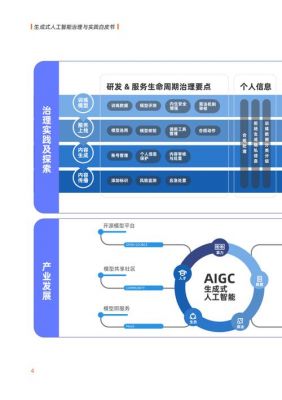

构建全生命周期的安全框架:这一框架能够覆盖模型从设计到部署多方位的安全检查,确保每个阶段都有相应的安全保障措施。

提升自我诊断与修复能力:未来的大模型需要具备自我检测和错误修复的能力,以减少潜在的安全风险。

防范隐私泄露与对抗性攻击:在评估过程中必须高度警惕隐私信息的泄露,以及对抗者利用模型的安全漏洞对系统发起攻击的可能性。

《2024生成式大模型安全评估白皮书》为行业提供了一套全面、系统的安全评估框架,既适用于研究人员,也为企业在使用大模型时提供了切实可行的指导。未来,随着技术的不断进步,生成式大模型将在未来的社会和经济中扮演更为重要的角色,因此,确保其安全性将是全行业必须共同面对和解决的重要课题。