Meta AI推出Token-Shuffle,突破自回归模型高分辨率图像生成瓶颈

时间:2025-07-19 04:15

小编:星品数码网

科技领域的不断创新推动了人工智能(AI)技术的快速发展,许多公司纷纷投入资源去探索更多的可能性。最近,Meta AI宣布推出了一种名为Token-Shuffle的新方法,旨在解决当前自回归(Autoregressive,AR)模型在生成高分辨率图像时所面临的扩展瓶颈问题。这一创新为AI图像生成技术带来了新的希望,也标志着Meta AI在多模态生成领域的进一步突破。

自回归模型作为一种广泛应用于数据预测的统计工具,虽然在语言生成中取得了显著成功,但是在处理高分辨率图像生成时,这种模型的局限性愈加明显。 AR模型工作的基础是依赖历史数据来预测未来值,而对于图像生成,尤其是高分辨率图像,所需的token数量往往呈指数级增长。这不仅使得计算成本急剧增加,也限制了其在高质量图像生成应用中的可行性。

根据Meta AI的研究,高分辨率图像生成需要数千个token进行处理,这对当前基于AR的许多多模态模型构成了极大的挑战。尽管近年来扩散模型(Diffusion Models)在高分辨率图像生成中表现出色,但其复杂的采样过程和相对较慢的推理速度也限制了其应用范围。因此,寻找一种能够有效降低计算成本,同时保持图像质量的方法成为了研究的一个热点。

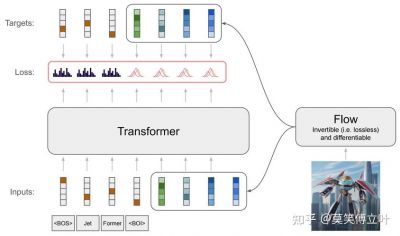

Token-Shuffle正是应对上述挑战而提出的一种创新解决方案。该方法利用了多模态大语言模型(MLLMs)在视觉token维度上的冗余,通过对空间上相邻的视觉token进行通道层面的合并,在Transformer处理过程前进行token的压缩,从而显著降低计算需求。推理完成后,Token-Shuffle再通过“解混合”步骤恢复原来的空间结构,确保生成图像的质量不受影响。

具体Token-Shuffle方法包括两个核心步骤:token-shuffle(token混合)和token-unshuffle(token解混合)。在输入准备阶段,通过多层感知机(MLP)将空间相邻的token压缩为单个token,从而大幅度减少处理所需的token数量。例如,假设窗口的大小为s,token的数量可以减少到原来的1/s²,这会降低Transformer的计算复杂度(FLOPs)。

Token-Shuffle还引入了一种新的调度器——classifier-free guidance(CFG),该调度器能够动态调整生成过程中的引导强度,从而优化文本与图像之间的对齐效果。这种方法的灵活性和高效性,使得Token-Shuffle不仅具有良好的兼容性,还能在现有的Transformer架构之上进行实现,避免了复杂的重构流程和额外的预训练需求。

在近期的实验中,Token-Shuffle在两个重要基准测试——GenAI-Bench和GenEval中显示了其强大的性能。使用基于2.7B参数的LLaMA模型,Token-Shuffle在GenAI-Bench的“困难”测试中获得了VQAScore 0.77的得分,超越了很多竞品AR模型,如LlamaGen(提高0.18)和扩散模型LDM(提高0.15)。在GenEval基准测试中,Token-Shuffle的综合得分更是达到了0.62,为自回归模型设立了新的标杆。

值得注意的是,尽管Token-Shuffle在逻辑一致性方面略逊于扩散模型,但在文本对齐和生成图像的质量方面,却显著优于其他AR模型,比如LlamaGen和Lumina-mGPT。这一结果不仅展示了Token-Shuffle的潜力,更为自回归模型的应用开辟了新的道路,特别是在对高分辨率图像生成的需求日益增加的背景下。

Meta AI推出的Token-Shuffle方法为解决自回归模型生成高分辨率图像的难题提供了有效的解决方案。其创新的token融合策略,大幅降低了计算成本,同时保持了视觉质量,使得自回归模型在图像生成领域的表现更加突出。未来,随着技术的不断发展和完善,Token-Shuffle有望带来更多的应用场景和行业解决方案,推动AI图像生成技术的进一步发展。