Ollama推出自主研发多模态AI引擎,摆脱对llama.cpp依赖

时间:2025-07-16 17:30

小编:星品数码网

在人工智能的快速发展中,开源大语言模型逐渐成为各行各业关注的焦点。近日,Ollama团队宣布推出一款自主研发的多模态AI引擎,标志着其正式摆脱了对于llama.cpp框架的依赖,引发了广泛的讨论和关注。

背景与变革

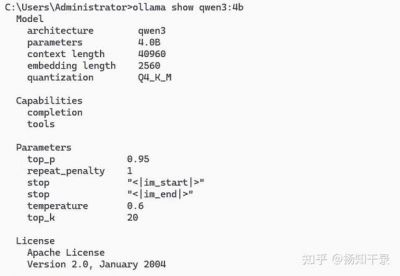

根据科技媒体WinBuzzer的报道称,Ollama的这一新引擎尤为重要,特别是在面对Meta的Llama 4、谷歌的Gemma 3、阿里巴巴的Qwen 2.5 VL以及Mistral Small 3.1等新一代高级模型时,现有的技术架构已经无法满足市场的复杂需求。Ollama团队在Hacker News上对此进行了澄清,强调了推出新引擎的必要性和迫切性。

随着大规模图像数据和多种输入形式的广泛应用,AI模型处理的复杂性大幅提升,传统的框架和工具在高负载情况下普遍存在性能瓶颈。因此,Ollama团队决定自主研发引擎,以满足不断增长的技术需求并确保其在AI领域的竞争力。

关键技术创新

新引擎的推出,Ollama团队在多个技术环节上进行了深入的挖掘与创新。在图像处理方面,该引擎引入了附加元数据处理功能,这使得在批量处理和位置数据管理上的效率得以显著提升。通过这项技术,团队避免了传统图像分割错误所导致的输出质量下降。这一改进不仅增强了引擎在处理复杂图像生成任务时的表现,也大幅减少了因为处理错误而增加的资源消耗。

值得一提的是,新引擎还集成了KVCache优化技术,极大提升了transformer模型的推理速度,使得系统在高并发情况下也能流畅运行。这样一来,Ollama在面临大规模并行查询时,确保了整体响应能力,给用户带来了更好的体验。

内存管理和硬件合作

除了在算法优化方面的创新,Ollama的新引擎在内存管理上也做出了重大提升。引擎新增的图像缓存功能确保生成的图像经过处理后可以被反复使用,避免了因提前丢弃而导致的资源浪费。Ollama团队还联合了一系列知名硬件制造商,包括NVIDIA、AMD、Qualcomm、Intel和Microsoft。通过与这些公司合作,Ollama能够精准检测硬件元数据,从而优化内存的使用估算。这一跨界合作为Ollama的技术发展提供了强有力的支持。

未来展望

Ollama的新引擎并不是一次单一的技术更新,而是围绕着未来的多功能性和灵活性进行设计的。团队表示,未来将计划继续支持更长的上下文长度、复杂推理过程以及工具调用流式响应。这些功能的实现将会进一步增强本地AI模型的适应能力和应用范围,使得用户在不同场景下均能享受到高效、准确的AI体验。

随着多模态AI的崛起,Ollama的新引擎也积极跟进,未来将可能整合更多的输入形式和数据类型,全面提升模型的处理能力。这一进程不仅可能影响Ollama自家的技术生态,也将对整个AI行业产生深远的影响。

Ollama重新定义了大语言模型的发展轨迹,以其自主研发的多模态AI引擎摆脱了对llama.cpp的依赖,显示出技术自立的决心和能力。通过不断的创新与优化,Ollama为未来的AI技术发展打开了新的可能性,同时也让整个行业对自主研发的力量有了更深刻的认识。随着这些技术的落地,我们期待Ollama在未来能为用户带来更多惊喜,也希望这股创新的浪潮能够推动整个AI领域的持续进步。