AI巨头面临模型发展瓶颈,收益递减困境凸显

时间:2024-11-16 08:15

小编:小世评选

最近,全球多家知名人工智能公司如OpenAI、谷歌和Anthropic相继发出警报,表示在高级AI模型的开发过程中遭遇了前所未有的瓶颈,进入了一个收益递减的阶段。这一现象在技术迅猛发展的背景下,显得尤为突兀。

根据彭博社的报道,OpenAI近期推出的Orion模型在编程任务的表现上较之前的GPT-4并没有展现出显著改进,令业内人士感到失望。同样,谷歌即将发布的Gemini软件面临着类似的困难,其性能提升的预期未能变为现实。而Anthropic则推迟了计划中的Claude 3.5 Opus模型的发布,这个令人期待的模型原本被寄予厚望。

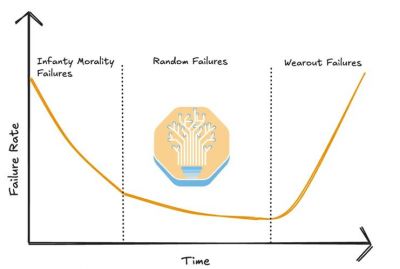

这一系列问题的根源在于人工智能领域对于高质量训练数据的依赖。当今的深度学习模型需要大量数据进行训练,但现有的训练数据越来越难以满足新模型对质量和多样性的需求。AI公司在开发新模型的同时,也需要继续维护和运营旧模型,这导致了巨大的资金和人力成本。专家指出,硅谷一直以来的理念认为,计算能力、数据量和模型规模的简单增加将自动提升模型性能,甚至可以实现通用人工智能(AGI),然而这一看法可能并不准确。

为了应对这些挑战,AI业界正在积极探索新的解决方案。一个显著的趋势是在人类反馈的基础上对模型进行进一步优化。例如,在模型的初步训练完成后,通过引入人类指导来改善模型的回答质量和语气,从而提升用户体验。许多公司开始开发一些专门针对特定任务的AI工具。这类工具被称为“代理”,如协助用户预订航班、发送电子邮件等。这种方式不仅可以降低模型开发的复杂性,还能够更好地满足用户的实际需求。

Hugging Face的首席伦理科学家Margaret Mitchell指出,“AGI的泡沫可能正逐渐破裂”,并且要想在多种任务上获得良好表现,可能需要采用截然不同的训练方式。此观点得到了众多科技专家的共鸣,他们普遍认为,未来的AI发展需要更多的创新思维和方法论,而不仅仅依赖于现有的技术框架。

随着诸如生成对抗网络(GAN)和强化学习等新兴技术的不断探索,业界也在尝试丰富AI技术的生态。例如,通过利用小样本学习和迁移学习,AI模型能够在较少的数据条件下实现良好的泛化能力,这可能是缓解当前瓶颈的一条重要路径。

许多专家指出,随着AI技术的快速进步,行业监管也面临着严峻挑战。如何在推动创新和确保安全之间找到平衡,将是企业和决策者需面临的另一大难题。未来,AI的应用场景将愈发广泛,从医疗、金融到交通、教育等领域均有潜在应用,但伴随而来的也可能是更多的伦理和法律风险。因此,构建一个稳定、安全且透明的AI生态系统显得尤为重要。

在人工智能领域,尽管AI巨头们面临着模型发展瓶颈和收益递减的困境,但通过技术创新和灵活的应对策略,行业仍有望走出困境。未来,AI的关键将不仅在于不断增加模型的规模和复杂性,更在于如何将技术与人类需求更好地结合,以及如何在技术进步的同时确保其安全和可控性。只有在这一底层逻辑出现变化之时,人工智能行业才能迎来新的春天。在这个过程中,变革和适应显得极为重要,而每一个参与者都需在创新的道路上不断探索和尝试。