英伟达Blackwell GPU在AI训练中成绩优异:速度比Hopper快2.2倍

时间:2024-11-16 05:05

小编:星品数码网

近日,科技媒体WccfTech报道了英伟达在AI训练工作负载中的最新成果,特别是在MLPerf v4.1基准测试中的表现。据悉,英伟达首次公布了其新一代Blackwell GPU的相关数据,显示其在训练Llama 2 70B(微调)模型时,比前一代Hopper GPU快了2.2倍。这一成绩不仅展示了Blackwell GPU的强大性能,也为未来深度学习和AI训练的进步提供了重要支撑。

测试背景及模型选择

在此次测试中,英伟达所使用的模型是目前AI领域中的一些重要代表,包括Llama 2 70B(LLM微调)、Stable Diffusion(文本到图像生成)、DLRMv2(推荐系统)、BERT(自然语言处理)、RetinaNet(目标检测)、以及GPT-3 175B(LLM预训练)和R-GAT(图神经网络)等。这些模型覆盖了多个AI应用领域,能够真实反映GPU在多样化任务下的性能表现。

自英伟达在今年8月首次亮相Blackwell GPU以来,业界对其性能的期待一直居高不下。而此次在MLPerf v4.1的成绩,首次突显了Blackwell在AI训练领域的领先地位。随着AI模型和应用需求的不断增长,计算能力的提升成为亟需解决的问题,Blackwell的发布为这一需求提供了有效的解决方案。

Blackwell GPU的技术优势

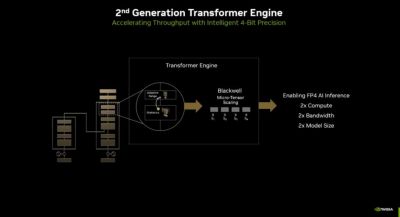

Blackwell GPU在设计上重视计算吞吐量的提高,配备了更大更快的高带宽内存。这使得其在不牺牲性能的前提下,能够在更少的GPU上进行复杂的模型训练。例如,测试结果显示,64张Blackwell GPU的性能达到了256张Hopper GPU的水平。这一惊人的数据不仅反映了Blackwell的强大性能,还表明英伟达在GPU架构设计上的深厚技术积累和创新能力。

Hopper GPU自发布以来,经过多轮的软件优化和更新,其性能在许多任务上也得到了显著提升。尤其是在LLM预训练的性能上,H100 GPU相较于首次提交时提高了1.3倍,并且在训练大型模型GPT-3(175B)时实现了70%的性能提升。这一系列优化使得Hopper虽然已经占据了一定的市场优势,但仍然无法与Blackwell的新一代技术相抗衡。

AI训练的未来趋势

随着AI领域的快速发展,对于计算能力的需求也在持续攀升。根据NVIDIA的观点,未来的AI研究和应用将需要更高效、更强大的计算能力。Blackwell的问世正是为了满足这一行业趋势,它代表了英伟达在GPU强劲性能和高效能计算方面的最新成果。

近年来,AI的应用已经从语音识别、自然语言处理,到图像生成、自动驾驶等多个领域全面开花。这一切都在推动更复杂的模型训练需求,因此,能够提供更强大计算能力的GPU将成为关键工具。Blackwell GPU以其卓越的性能,将为各行业的AI应用提供更加高效和经济的支持,为研究人员和开发者创造更便捷的工作环境。

英伟达Blackwell GPU在AI训练工作负载中的表现,充分验证了其强大的计算能力及技术优势。在MLPerf v4.1的基准测试中,Blackwell不仅在速度上超越了Hopper,也为AI领域的更高标准设定了新标杆。随着AI技术的不断演进,英伟达的持续创新将持续推动整个行业的进步,助力AI训练迎接新的挑战与机遇。

未来,我们期待看到Blackwell在更多应用场景中的表现,以及它与其他先进GPU技术的竞争与协作,为AI技术的发展开辟更广阔的前景。英伟达的黑科技,为我们描绘了一个更加智能的未来。